IREX - Conteneurisation et Déploiement Initial sur kubernetes

Déployer une application sur Kubernetes est essentiel dans un environnement cloud. Cet article vous guide pas à pas, depuis la création d’un conteneur Docker jusqu’à sa mise en ligne sur kubernetes

SOMMAIRE :

1. Introduction

Kubernetes est un système open-source d’orchestration de conteneurs, largement adopté pour automatiser le déploiement, la mise à l’échelle et la gestion d’applications conteneurisées. En parallèle, Docker permet de créer des images reproductibles et portables, étapes essentielles avant d’orchestrer sur Kubernetes.

Cet article se concentre sur le processus concret de déploiement d’une application : conteneurisation avec Docker, création et application d’un manifeste Kubernetes, exposition du service, mises à jour et aspects à surveiller. L’objectif est de fournir une feuille de route claire et opérationnelle, permettant de réussir un déploiement basique mais complet sur un cluster Kubernetes — compétence essentielle pour un ingénieur logiciel moderne.

2. Kubernetes : un aperçu

a. Qu'est-ce que Kubernetes ?

Kubernetes, souvent abrégé K8s, est un système d'orchestration de conteneurs open-source développé initialement par Google.

Pour faire simple, imaginez-le comme un chef d'orchestre intelligent qui coordonne et gère automatiquement des centaines, voire des milliers de conteneurs d'applications dans un cluster de serveurs.

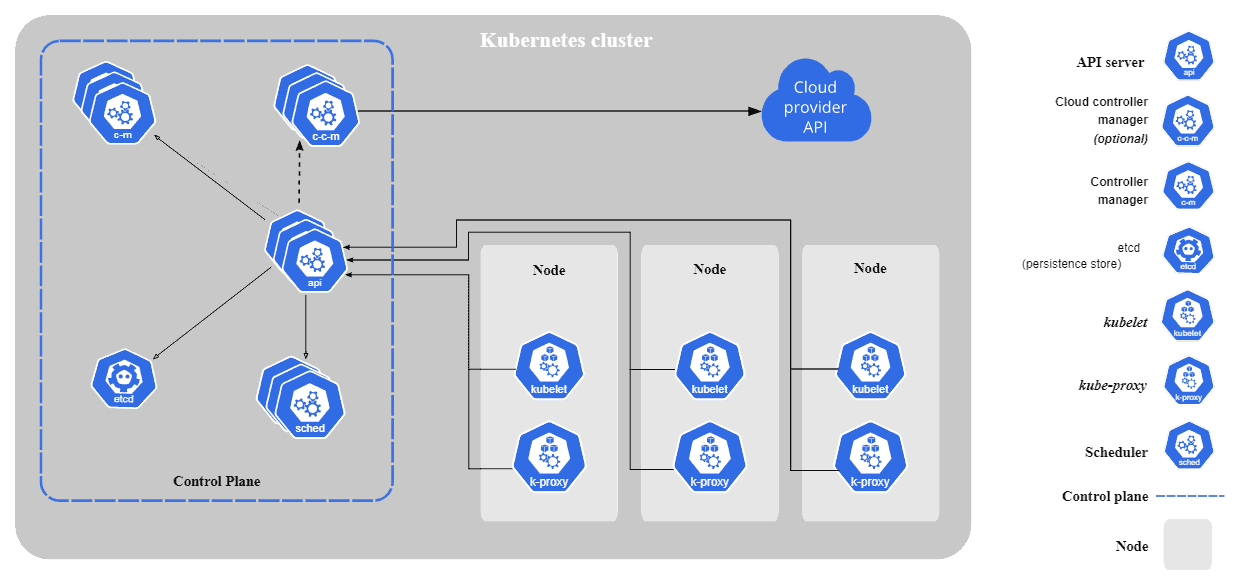

b. Architecture et composants clés

Kubernetes repose sur une architecture composée de plusieurs éléments essentiels :

- Control Plane : Le cerveau du cluster qui prend les décisions

- Nodes : Les machines de travail qui exécutent les applications

- Pods : L'unité de base d'exécution contenant un ou plusieurs conteneurs

- Services : Points d'accès réseau pour exposer les applications

- Deployments : Gestion du cycle de vie et de la réplication des Pods

c. Pourquoi Kubernetes révolutionne le déploiement

Automatisation intelligente : Kubernetes prend en charge le déploiement, la mise à l’échelle et la gestion des applications conteneurisées sans intervention manuelle constante.

Scalabilité dynamique : Il peut automatiquement augmenter ou diminuer le nombre d'instances d'une application en fonction de la charge en temps réel.

Résilience : Si un conteneur ou un nœud tombe en panne, Kubernetes redémarre automatiquement les applications sur des nœuds sains.

3. Docker : la fondation du déploiement moderne

a. Pourquoi Docker avant Kubernetes ?

Avant de maîtriser Kubernetes, il est essentiel de comprendre Docker. Kubernetes orchestre principalement des conteneurs Docker, ce qui fait de Docker la pierre angulaire du déploiement moderne. Docker résout le problème classique du "ça marche sur ma machine" en encapsulant l'application et toutes ses dépendances dans un conteneur portable.

b. Les avantages de la conteneurisation pour Kubernetes

Portabilité : Un conteneur fonctionne de manière identique sur n'importe quel nœud du cluster Kubernetes, garantissant une cohérence parfaite.

Isolation : Chaque Pod Kubernetes peut contenir des conteneurs isolés, évitant les conflits de dépendances entre applications.

Efficacité : Les conteneurs sont légers et démarrent rapidement, permettant à Kubernetes de faire de la mise à l'échelle dynamique efficace.

Reproductibilité : L'image Docker garantit que votre application se comportera exactement de la même façon sur tous les environnements Kubernetes (développement, test, production).

c. De Docker à Kubernetes

Alors que Docker excelle pour exécuter des conteneurs individuels, Kubernetes prend le relais pour orchestrer des centaines ou milliers de ces conteneurs à travers un cluster de machines. Docker gère le "comment" exécuter un conteneur, Kubernetes gère le "où", "quand" et "combien" de conteneurs exécuter.

4. Installation et configuration des outils

a. Prérequis système

Avant de commencer, assurez-vous d'avoir un système compatible (Windows 10/11 avec WSL2, macOS, ou Linux) avec au moins 4 GB de RAM disponible. Un environnement de développement moderne nécessite également des droits d'administrateur pour l'installation des outils.

b. Installation de Docker

Sur Windows : Téléchargez Docker Desktop depuis le site officiel. L'installation inclut automatiquement WSL2 si nécessaire. Redémarrez après installation et vérifiez que Docker fonctionne.

Sur macOS : Docker Desktop pour Mac s'installe comme toute application classique. Il inclut un environnement Linux virtualisé optimisé.

Sur Linux : Utilisez le gestionnaire de packages de votre distribution ou le script d'installation officiel. Ajoutez votre utilisateur au groupe 'docker' pour éviter d'utiliser sudo.

c. Installation de kubectl

kubectl est l'outil en ligne de commande pour interagir avec Kubernetes. Il peut être installé via les gestionnaires de packages système (apt, brew, choco) ou téléchargé directement. Une fois installé, kubectl doit être configuré pour se connecter à un cluster.

d. Environnement de test local

Minikube : La solution la plus populaire pour créer un cluster Kubernetes local. Il s'installe facilement et permet de simuler un environnement multi-nœuds sur une seule machine.

Kind (Kubernetes in Docker) : Alternative légère qui crée des clusters Kubernetes dans des conteneurs Docker. Idéal pour les tests rapides et l'intégration continue.

Docker Desktop Kubernetes : Docker Desktop inclut un cluster Kubernetes intégré qu'on peut activer d'un clic. Parfait pour débuter sans configuration supplémentaire.

e. Accès aux clusters cloud

Services managés : Les principaux fournisseurs cloud (AWS EKS, Google GKE, Azure AKS) proposent des clusters Kubernetes managés. Ils fournissent des outils CLI spécifiques pour la configuration de kubectl.

Configuration : Chaque provider fournit des commandes pour configurer automatiquement kubectl avec les bonnes credentials et endpoints. Cette configuration se fait via des fichiers kubeconfig.

f. Validation de l'installation

Une fois tous les outils installés, validez votre environnement en créant un Pod de test, en listant les nœuds du cluster, et en consultant les logs. Cette vérification garantit que votre environnement est prêt pour les déploiements.

5. Processus de déploiement avec Kubernetes

a. Préparation : Conteneurisation de l'application

La première étape consiste à créer un Dockerfile optimisé. Cette étape est cruciale car elle détermine la qualité, la sécurité et la performance de votre conteneur. Les bonnes pratiques incluent l'utilisation de builds multi-stage pour réduire la taille de l'image finale, la création d'utilisateurs non-privilégiés pour la sécurité, et l'optimisation des couches pour améliorer la mise en cache.

Une approche moderne consiste à séparer la phase de construction (avec tous les outils de développement) de la phase de production (avec seulement les éléments nécessaires à l'exécution). Cette méthode permet d'obtenir des images plus légères et plus sécurisées.

b. Création des manifestes Kubernetes

Kubernetes utilise des fichiers YAML appelés "manifestes" pour décrire l'état souhaité de vos applications. Les principaux types de ressources sont :

Deployment : Définit comment votre application doit être déployée, combien d'instances (replicas) doivent tourner, et quelle stratégie de mise à jour utiliser. Il gère automatiquement la création et la suppression des Pods selon vos spécifications.

Service : Expose votre application au réseau. Il agit comme un load balancer interne qui distribue le trafic entre vos différentes instances d'application. Même si vos Pods redémarrent et changent d'adresse IP, le Service maintient un point d'accès stable.

ConfigMap et Secret : Permettent d'externaliser la configuration de votre application. Les ConfigMaps stockent les données non-sensibles tandis que les Secrets chiffrent les informations confidentielles comme les mots de passe et clés API.

c. Déploiement et vérification

Une fois vos manifestes prêts, le déploiement se fait via la commande kubectl apply. Cette commande compare l'état souhaité (vos manifestes) avec l'état actuel du cluster et effectue les modifications nécessaires.

La vérification du déploiement implique plusieurs étapes : s'assurer que les Pods démarrent correctement, que les Services exposent bien l'application, et que les health checks passent. Kubernetes fournit de nombreuses commandes pour surveiller l'état de vos déploiements en temps réel.

6. Aspects critiques du déploiement en production

a. Sécurité

Gestion des secrets : Une règle fondamentale en production est de ne jamais inclure de mots de passe ou clés API directement dans vos images Docker ou manifestes. Kubernetes propose les ConfigMaps pour les données de configuration non-sensibles et les Secrets pour les informations confidentielles qui sont automatiquement chiffrées.

RBAC (Role-Based Access Control) : Permet de contrôler précisément qui peut faire quoi dans votre cluster. Chaque utilisateur ou service n'a accès qu'aux ressources strictement nécessaires à son fonctionnement.

Network Policies : Sécurisent la communication entre Pods en définissant des règles de trafic réseau, similaires à un firewall interne au cluster.

b. Monitoring et observabilité

Health checks : Kubernetes peut automatiquement vérifier la santé de vos applications via deux types de sondes :

- Liveness probe : Vérifie si l'application fonctionne et la redémarre si nécessaire

- Readiness probe : Détermine si l'application est prête à recevoir du trafic

Métriques et logs : L'intégration avec des outils comme Prometheus pour les métriques et Grafana pour la visualisation permet un monitoring complet de vos applications en temps réel.

c. Gestion des données et persistance

Volumes persistants : Pour les applications qui ont besoin de stocker des données (comme les bases de données), Kubernetes propose un système de volumes persistants qui survivent aux redémarrages des Pods.

Stratégies de sauvegarde : La planification de sauvegardes automatiques et régulières des données critiques est essentielle pour garantir la continuité de service.

7. Stratégies de déploiement avancées

a. Rolling Update (Mise à jour progressive)

La stratégie par défaut de Kubernetes permet de mettre à jour les applications sans interruption de service. Elle remplace progressivement les anciennes versions par les nouvelles, en s'assurant qu'un minimum d'instances reste toujours disponible.

Avantages : Zéro downtime, rollback automatique en cas d'échec

Inconvénients : Versions multiples temporairement actives

b. Blue-Green Deployment

Cette stratégie utilise deux environnements identiques (Blue et Green) où un seul reçoit le trafic à la fois. Vous déployez la nouvelle version sur l'environnement inactif, testez, puis basculez tout le trafic instantanément.

Avantages : Basculement instantané, rollback rapide, tests en conditions réelles

Inconvénients : Double consommation de ressources

c. Canary Deployment

Déploiement progressif où la nouvelle version ne reçoit qu'un petit pourcentage du trafic (ex: 10%), permettant de valider le comportement avant un déploiement complet. Le pourcentage peut être augmenté graduellement.

Avantages : Test en conditions réelles avec risque limité, feedback rapide

Inconvénients : Complexité de configuration, monitoring accru nécessaire

d. Outils d'automatisation du déploiement

Helm : Surnommé le "gestionnaire de packages pour Kubernetes", Helm simplifie le déploiement et la gestion des applications complexes via des "charts" réutilisables.

ArgoCD : Outil de déploiement continu basé sur GitOps. Il surveille vos dépôts Git et synchronise automatiquement l'état du cluster avec le code versionné.

e. Mise à l'échelle automatique

Horizontal Pod Autoscaler (HPA) : Ajuste automatiquement le nombre de replicas en fonction de métriques comme l'utilisation CPU ou mémoire.

Vertical Pod Autoscaler (VPA) : Ajuste automatiquement les ressources (CPU/Memory) allouées aux conteneurs selon leur utilisation réelle.

Cluster Autoscaler : Ajoute ou supprime des nœuds dans votre cluster selon la demande, optimisant les coûts d'infrastructure.

8. Conclusion

Le déploiement sur Kubernetes représente une évolution majeure dans la gestion des applications modernes. De la conteneurisation avec Docker aux stratégies de déploiement avancées, chaque étape nécessite une compréhension approfondie des enjeux techniques et métier.

Cette exploration technique montre que Kubernetes n'est pas seulement un outil d'orchestration, mais un écosystème complet qui transforme notre approche du déploiement : automatisation, résilience, scalabilité et observabilité deviennent les piliers d'une infrastructure moderne.

9. Illustration vidéo

10. Voir aussi

Vous pouvez consulter ces autres articles :

hapket darelle maouchca

etudiante a ENSPY

No comments yet. Start a new discussion.