IREX - Docker et la communication inter-processus : ports, noms et adresses IP

Tu t'es déjà demandé comment les conteneurs Dockers communiquent-ils entre eux ?

Docker et la communication inter-processus : ports, noms et adresses IP

Sommaire

1. Introduction

Docker a révolutionné la façon dont on conçoit et déploie des applications. Sa force ne réside pas seulement dans l’isolation, mais dans la capacité à orchestrer plusieurs services qui communiquent entre eux.

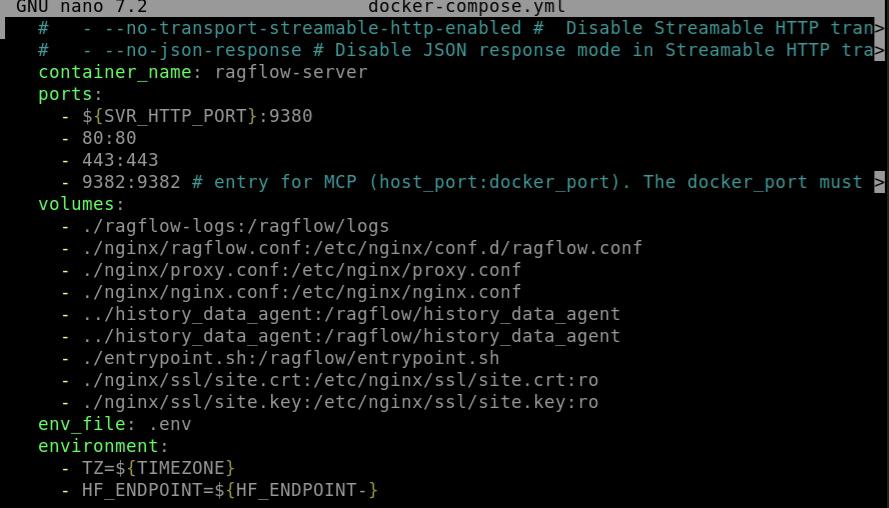

J’ai personnellement été confronté à cette problématique lors de la mise en place de Ragflow derrière Nginx. Chaque service semblait fonctionner seul, mais dès qu’il fallait les faire collaborer, j’ai découvert l’importance des trois piliers de la communication inter-processus : les ports, les noms et les adresses IP.

2. Les ports : exposer et sécuriser les services

Les ports sont la passerelle entre le monde interne d’un conteneur et l’extérieur. Sans eux, un conteneur reste invisible. Avec eux, on choisit ce qui doit être accessible et à quel endroit.

docker run -p 8080:80 nginxIci, le port 80 du conteneur est accessible depuis le port 8080 de la machine hôte. C’est ce mécanisme qui m’a permis d’ouvrir Ragflow via Nginx. Mais attention : chaque port exposé est une porte ouverte. Une base de données ou un service interne ne devrait jamais être accessible directement de l’extérieur.

3. Les noms de conteneurs : un DNS intégré

Dans un réseau Docker, les noms de services agissent comme un mini-DNS.

Plus besoin de courir après les adresses IP changeantes, il suffit d’utiliser le nom défini dans

docker-compose.yml.

services:

ragflow:

image:v0-20-slim

nginx:

image: nginx:latest

Ici, ragflow peut se connecter à nginx

C’est exactement ce que j’ai dû mettre en place pour que Nginx redirige correctement vers Ragflow.

4. Les adresses IP : comprendre la couche réseau

Chaque conteneur a une IP attribuée dynamiquement dans le réseau Docker. En pratique, on peut s’y connecter, mais elles changent régulièrement, rendant toute configuration basée sur l’IP fragile.

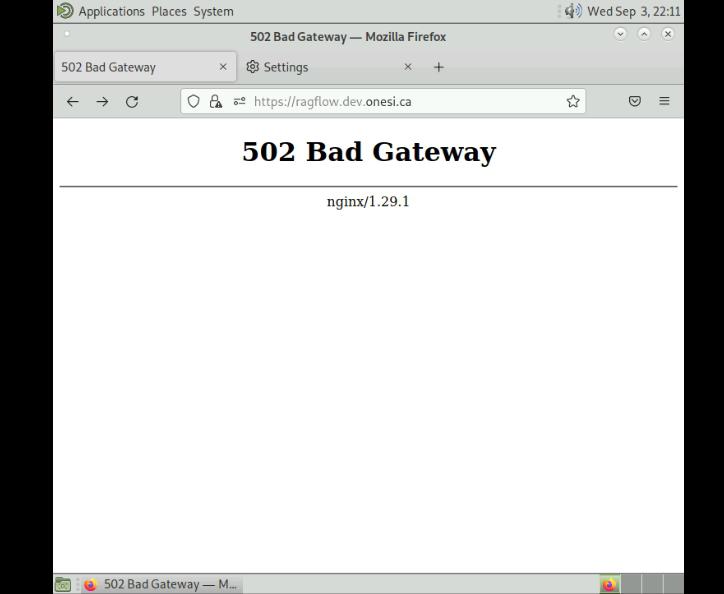

Lors de mes tests, j’ai tenté d’utiliser l’IP de Ragflow dans la configuration Nginx. Cela fonctionnait… jusqu’au redémarrage. Résultat : impossible d’accéder à l’application, j’ai donc appris à toujours préférer les noms de services.

5. Exemple détaillé : architecture 3 tiers

Voici un schéma simplifié de l'architecture que j'ai deploye, où un frontend Nginx, et Ragflow communiquent dans un même réseau Docker.

version: '3'

services:

nginx:

image: nginx-latest

ports:

- "8080:80"

- "443:443"

networks:

- appnet

Ragflow:

image: v0-20-slim

ports:

- "9340:9340"

networks:

- appnet

depends_on:

- nginx

networks:

appnet:

- Ragflow se connecte a nginx via le port 9340 - nginx expose les ports 80 et 443 et rends ragflow accessible sur ces ports

6. Erreurs fréquentes rencontrées

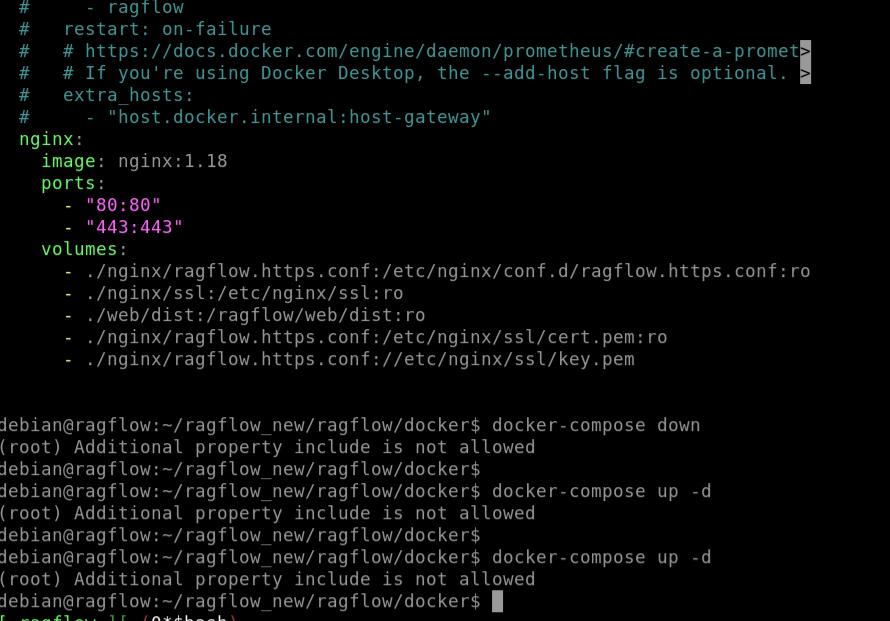

Erreur 1 : Conflit de réseaux

Lors d’une configuration initiale, j’ai relié mes conteneurs à deux réseaux différents par inadvertance.

Résultat : ils étaient incapables de se joindre, malgré une configuration correcte des ports.

Solution : vérifier avec docker network inspect que tous les services appartiennent au même réseau logique.

Erreur 2 : Mauvais mapping des ports

J’ai déjà oublié de publier un port, ce qui rendait Ragflow inaccessible depuis l’hôte.

Solution : toujours vérifier les lignes -p dans docker-compose.yml et confirmer avec docker ps.

Erreur 3 : Utilisation d’une IP éphémère

En reliant Nginx à l’IP directe de Ragflow, tout fonctionnait… jusqu’à un redémarrage.

Solution : toujours utiliser le nom du service, beaucoup plus fiable.

7. Bonnes pratiques

- Limiter l’exposition des ports, seuls les reverse proxies doivent s’ouvrir vers l’extérieur.

- Utiliser des noms de services cohérents et explicites.

- Isoler les environnements via des réseaux distincts.

- S’appuyer sur

docker-composepour simplifier la gestion multi-services. - Documenter les erreurs rencontrées pour éviter de répéter les mêmes pièges.

8. Conclusion

Comprendre la communication inter-processus dans Docker, c’est comme apprendre à traduire entre des langues différentes : ports, noms et IPs. Une fois ces mécanismes acquis, configurer Nginx pour Ragflow ou pour une autre application devient beaucoup plus naturel.

Mais à grande échelle, ces principes sont prolongés par des outils comme Kubernetes, qui apportent un DNS interne avancé, du load balancing et une véritable orchestration réseau.

9. Voir aussi

Fokouo saadie Luciano

Étudiant en Data Science passionné par le Deep Learning et l'IA. Curieux et autodidacte, j'aime explorer les algorithmes, modèles et défis de l'intelligence artificielle. Objectif : contribuer à des projets innovants et repousser les limites de la tech.

No comments yet. Start a new discussion.